Когда мы заходим в мир программирования, проникаем в безграничные возможности создания и управления информацией. Но что является основой всех этих чудес? Какие секреты таит в себе бескрайний код, благодаря которому раскрывается весь потенциал цифровой реальности?

Для нас, программистов, важно знать и понимать суть наиболее базовых цифр – "0" и "1". Казалось бы, какое отношение эти две цифры так далеко оставшиеся от середины числового спектра имеют к программированию? Однако, они являются фундаментом, с которого начинается вся система порядка в компьютере и ПО в целом.

Великий английский математик Джордж Буль в своих работах акцентировал внимание на двоичной системе счисления. Всего две цифры представляют наиболее главные составляющие всех компьютерных операций и функций. "0" и "1" – это способ кодирования информации и хранения данных на компьютере, определяющий все его возможности. Основатели программирования, начиная с Ады Лавлейс и Чарльза Беббеджа, представили весь этот алфавит в компьютерной науке, опираясь на идею двоичной системы.

Основа компьютерных систем: роль нуля и единицы

В современном мире компьютерные системы проникают во все сферы нашей жизни: от технологических процессов и электронной коммерции до нашего повседневного использования смартфонов и компьютеров. Все эти мощные устройства в основе своей работают с помощью двух чисел: нуля и единицы. В этом разделе мы изучим, какую жизненно важную роль играют эти две основные цифры в функционировании компьютерных систем.

Нуль и единица являются фундаментальными элементами внутренних операций компьютера. Они сотрудничают вместе для представления информации, обработки данных и выполнения различных действий. Ноль представляет отсутствие сигнала или выключено состояние, тогда как единица указывает на присутствие сигнала или включено состояние. Эта пара двоичных цифр образует бинарный код, который является основой для записи и обработки информации в компьютерных системах.

Необходимость использования только этих двух цифр обусловлена особенностями электронных устройств. Все элементы компьютера, такие как микрочипы, провода и транзисторы, основаны на принципах электрических сигналов, а именно на проводимости и непроводимости электрического тока. Ноль и единица синтезируют эти два состояния и позволяют всей системе работать с высокой скоростью и надежностью.

Применяя бинарный код, компьютерные системы могут представлять любые данные, символы, числа и алгоритмы. Число нулей и единиц в последовательности определяет различные комбинации и значения, что позволяет компьютеру выполнить широкий спектр задач. Понимание роли нуля и единицы в компьютерных системах является важным шагом в освоении основ программирования и работы с этими технологиями, которые стали неотъемлемой частью нашей современной жизни.

Базовые понятия: биты, байты и битовые операции

Бит является основным элементом информации в компьютере. Он может принимать только два значения: 0 или 1. Двоичные числа состоят из последовательностей битов и используются для представления данных в цифровой форме. Набор из 8 битов называется байтом, который является минимальной адресуемой единицей памяти в компьютере.

В программировании существуют различные битовые операции, которые позволяют выполнить различные манипуляции с битами. Например, можно выполнять операции "И" (AND), "ИЛИ" (OR), "Исключающее ИЛИ" (XOR) и сдвиги влево/вправо. Битовые операции широко применяются для манипуляций с флагами, маскирования и различных других задач, связанных с обработкой двоичных данных.

- Бит - основной элемент информации в компьютере.

- Байт - набор из 8 битов, минимальная адресуемая единица памяти.

- Двоичные числа - представление данных в цифровой форме.

- Битовые операции - выполняют манипуляции с битами, включая "И", "ИЛИ", "Исключающее ИЛИ" и сдвиги.

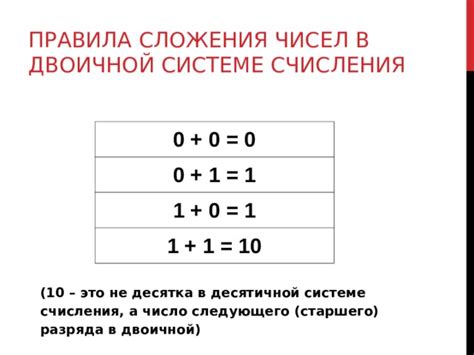

Роль 0 и 1 в двоичной системе счисления

Двоичная система счисления имеет особое значение в мире программирования и компьютерных технологий. Она отличается от десятичной системы, которую мы привыкли использовать в повседневной жизни, и основана на использовании только двух цифр: 0 и 1. Эти две простые цифры играют ключевую роль в представлении информации и действиях, выполняемых компьютерами.

0 и 1 в двоичной системе счисления могут интерпретироваться как логические значения: соответственно, ложь и истина. Такая простота и ясность имеют глубокое значение при создании и работе с программами и алгоритмами. Также стоит отметить, что двоичная система счисления является основой внутреннего представления информации в компьютерах и форматах данных, таких как байты и биты.

В программировании цифры 0 и 1 используются для представления двоичных чисел, которые в свою очередь используются для кодирования и обработки данных. Битовые операции, такие как AND, OR и XOR, позволяют выполнять различные логические операции над двоичными значениями. Также двоичные числа широко используются при выполнении битовых сдвигов и маскирования, что позволяет эффективно управлять и манипулировать информацией.

Важно понимать, что двоичная система счисления является основой для работы компьютеров и программирования, и понимание роли цифр 0 и 1 в этой системе помогает построить более глубокое понимание принципов и алгоритмов, которые лежат в основе различных программных решений.

Двоичная система счисления и ее применение в программировании

Для понимания двоичной системы счисления необходимо отказаться от привычного десятичного подхода и перейти к использованию всего двух цифр. Каждая цифра в двоичной системе имеет свое весовое значение, которое увеличивается в два раза с каждым следующим разрядом. Например, первый разряд имеет весовое значение 1, второй разряд - 2, третий - 4 и так далее.

Применение двоичной системы счисления в программировании связано с особенностями работы с цифровой информацией. Компьютеры оперируют данными в виде двоичного кода, используя 0 и 1 для представления информации. Это позволяет эффективно хранить, обрабатывать и передавать данные.

В программировании двоичная система счисления используется для работы с битами, которые являются основными строительными блоками информации. Биты позволяют представить два возможных состояния - 0 или 1. Они используются для хранения различных типов данных, выполнения логических операций, управления сигналами и многих других задач.

| Десятичная цифра | Двоичная цифра |

|---|---|

| 0 | 0 |

| 1 | 1 |

Конвертация чисел между десятичной и двоичной системами счисления

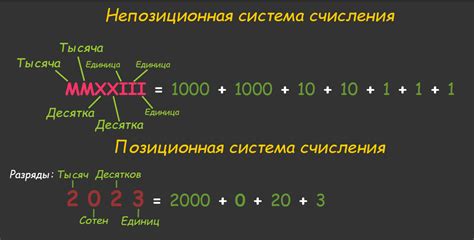

Конвертация чисел из десятичной системы счисления в двоичную позволяет представить числа в компьютере в более компактном и эффективном формате. Двоичная система счисления состоит из только двух цифр - 0 и 1, поэтому каждая цифра представляет степень двойки.

| Десятичное число | Двоичное представление |

|---|---|

| 0 | 0 |

| 1 | 1 |

| 2 | 10 |

| 3 | 11 |

| 4 | 100 |

Для выполнения конвертации чисел из десятичной системы в двоичную можно использовать различные методы и алгоритмы. Одним из наиболее простых и эффективных является метод деления на 2. Суть метода заключается в последовательном делении десятичного числа на 2 и записи остатков от деления в обратном порядке.

В обратную сторону, из двоичной системы счисления в десятичную, конвертация также возможна. Для этого необходимо использовать алгоритм полиномиального разложения числа, где каждая цифра двоичного числа умножается на соответствующую степень двойки и суммируется.

Конвертация чисел между десятичной и двоичной системами счисления является важной темой в программировании и знание этих методов поможет разработчикам эффективно работать с числами в разных системах счисления.

Влияние 0 и 1 на работу цифровых устройств

Каждая цифра, будь то 0 или 1, имеет своё значение и роль в работе цифровых систем. Ноль представляет отсутствие сигнала или информации, а единица – наличие сигнала или информации. Сочетания и последовательности этих двух цифр позволяют передавать, хранить и обрабатывать данные в цифровых устройствах. Это позволяет создавать устройства с различной функциональностью и эффективностью.

| Цифра | Значение |

|---|---|

| 0 | Отсутствие сигнала или информации |

| 1 | Наличие сигнала или информации |

Цифровые устройства обрабатывают данные путем анализа и управления состояниями 0 и 1. Это позволяет им выполнять сложные операции с высокой точностью и скоростью. Например, в цифровых компьютерах эти две цифры используются для представления чисел, выполнения логических операций, обработки аудио- и видеоданных, а также для управления периферийными устройствами.

Использование 0 и 1 в программировании и разработке цифровых систем стало фундаментом современной информационной эры. Благодаря этим цифрам мы можем создавать и использовать различные электронные устройства, которые оказывают огромное влияние на нашу жизнь и общество в целом.

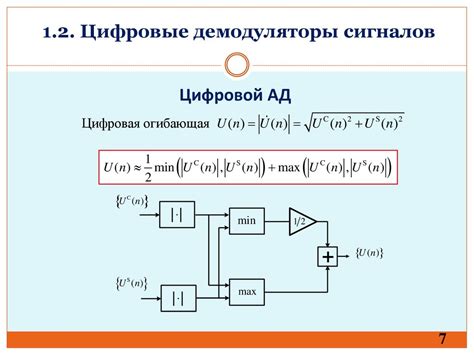

Цифровая электроника: главная задача передачи и обработки двоичных данных

Двоичная система счисления основана на идеи использования всего двух состояний, представленных цифрами 0 и 1. В отличие от десятичной системы, в которой мы привыкли считать, двоичная система является фундаментом для работы с электрическими сигналами в цифровой электронике. Она обеспечивает простоту и надежность передачи и обработки данных.

Основная задача цифровой электроники состоит в том, чтобы передавать, обрабатывать и хранить информацию в виде двоичных данных. Это достигается путем преобразования аналоговых сигналов, таких как звук или свет, в цифровые формы с помощью специальных устройств, называемых аналого-цифровыми преобразователями. Затем эти цифровые данные могут быть обработаны и переданы далее с использованием цифровых схем, включая процессоры и память.

| Преимущества передачи данных в двоичной форме | Примеры использования двоичной системы |

|---|---|

| Минимизация ошибок при передаче | Интернет-трафик, передаваемый через сети |

| Простота и эффективность обработки данных в цифровой форме | Компьютерные программы и алгоритмы |

| Удобство хранения и передачи больших объемов информации | Цифровые носители данных, такие как жесткие диски и флеш-накопители |

Таким образом, двоичные данные являются основой современных технологий и играют важную роль в цифровой электронике. Понимание работы и обработки этих данных позволяет разрабатывать более эффективные и надежные системы, способные обрабатывать огромные объемы информации.

Обработка сигналов: пример работы сигналов в цифровых устройствах

Мы уже разобрались с основами цифровой системы, а теперь пришло время погрузиться в удивительный мир обработки сигналов в цифровых устройствах. Сигналы играют важную роль в передаче и обработке информации, и особенно важно понимать, как они обрабатываются в контексте цифровых устройств.

Рассмотрим пример работы сигналов в цифровых устройствах на практике. Представим, что у нас есть микроконтроллер, который управляет светодиодом. Светодиод может быть в состоянии "включен" или "выключен". Для передачи информации о состоянии светодиода микроконтроллер использует двоичные сигналы, представленные нулями и единицами.

Например, если микроконтроллер отправляет сигнал "1", это означает, что светодиод должен быть включен. Если микроконтроллер отправляет сигнал "0", светодиод должен быть выключен. Таким образом, сигналы "0" и "1" позволяют микроконтроллеру передать управляющую информацию светодиоду и регулировать его состояние.

Важно отметить, что работа сигналов в цифровых устройствах основывается на использовании логических операций, которые позволяют комбинировать и обрабатывать сигналы. Например, посредством логической операции "И" можно проверять, чтобы сигналы на различных входах устройства были равны "1" для выполнения определенного действия.

Таким образом, обработка сигналов в цифровых устройствах является фундаментальной частью программирования и дизайна цифровых систем. Понимание работы сигналов позволяет создавать эффективные и надежные цифровые устройства, способные обрабатывать и передавать информацию точно и эффективно.

Вопрос-ответ

Зачем программированию понадобились цифры 0 и 1?

Цифры 0 и 1 в программировании используются для представления информации в двоичной системе счисления, которая является основой работы компьютеров. Благодаря использованию двоичной системы, компьютеры могут обрабатывать и хранить данные с помощью электрических сигналов, управляющихся с помощью включения и отключения электрического напряжения.

Какие ещё системы счисления используются в программировании, кроме двоичной?

Помимо двоичной системы счисления, в программировании также используются десятичная (основанная на числах от 0 до 9), восьмеричная (основанная на числах от 0 до 7) и шестнадцатеричная (основанная на числах от 0 до 9 и от A до F) системы счисления. Каждая из этих систем имеет свои особенности и используется для конкретных задач.

Как 0 и 1 помогают представить текст и изображения в компьютере?

В компьютере, текст и изображения представлены в виде последовательностей цифр 0 и 1, которые называются битами. Каждый символ или пиксель изображения представлен соответствующим кодом, где набор бит определяет его уникальную комбинацию. Компьютерные программы затем интерпретируют эти последовательности битов, чтобы отобразить конкретную информацию на экране или в текстовом формате.

Влияет ли использование цифр 0 и 1 на производительность компьютерных систем?

Использование цифр 0 и 1 в программировании имеет прямое влияние на производительность компьютерных систем. Так как компьютеры работают с двоичной системой счисления, они способны обрабатывать информацию быстрее и эффективнее, чем если бы они использовали другие системы счисления. Более того, использование двоичной системы позволяет компьютерам более надежно и точно сохранять и передавать данные.

Можно ли в программировании использовать только нули и единицы для работы с числами?

В программировании не ограничены использованием только нулей и единиц для работы с числами. Хотя в двоичной системе счисления только 0 и 1 используются для представления чисел, существуют различные системы кодирования и операции, которые позволяют работать с различными типами данных и производить математические операции в других системах счисления (например, десятичной). Также, в языках программирования существуют встроенные функции, которые упрощают работу с числами и другими типами данных.